¿Alguna vez has sentido esa pequeña chispa de frustración al usar un chatbot de IA? Sabes que la respuesta está ahí, pero tienes que leer párrafos interminables para encontrar un dato o entablar una conversación de diez minutos solo para agendar una cita.

Esa barrera invisible no es culpa de la inteligencia del modelo, sino de cómo se comunica con nosotros. Al final del día, los seres humanos somos visuales; necesitamos tocar, ver y seleccionar, no solo leer.

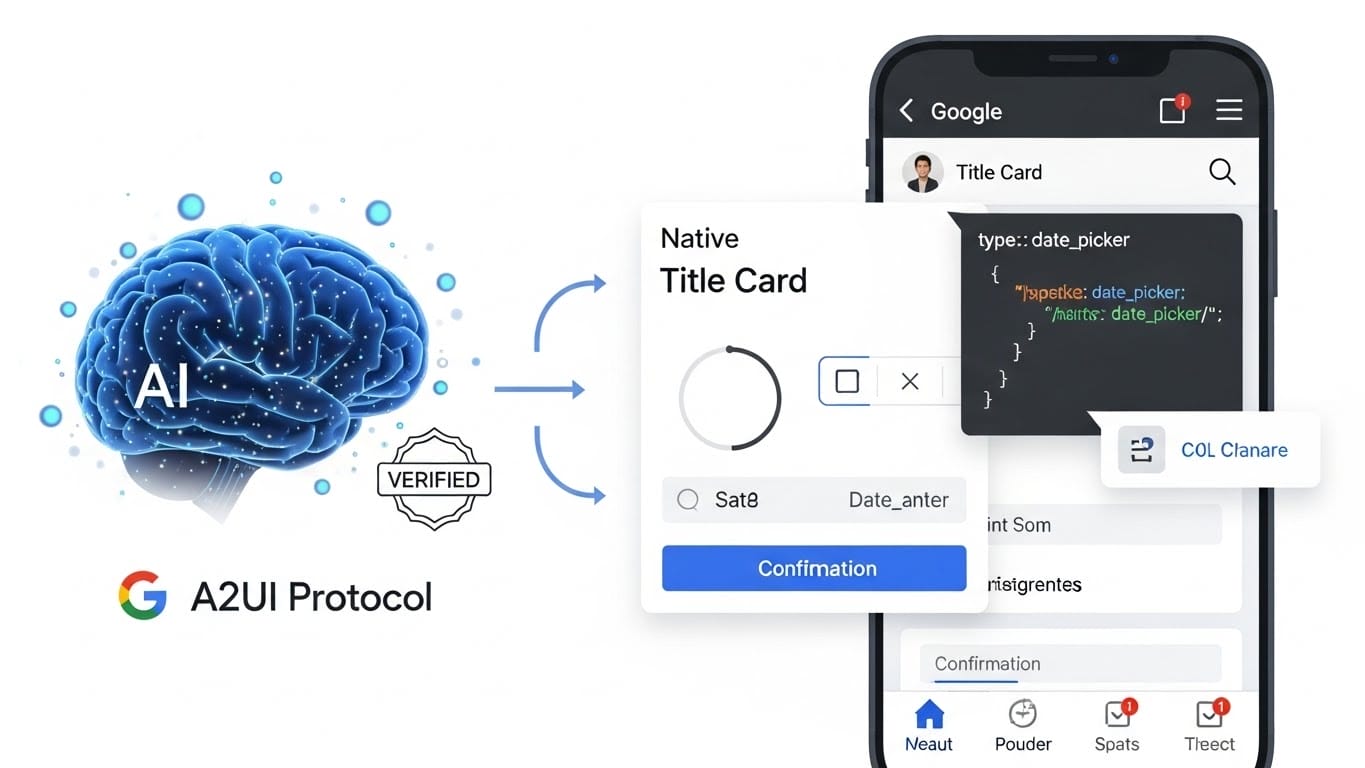

Google lo ha entendido y acaba de liberar A2UI (Agent-to-User Interface), un protocolo que promete humanizar la interacción con la IA, dándole, por fin, una cara visual, nativa y segura que se adapta a lo que tú necesitas en cada momento.

¿Qué es exactamente A2UI?

Si eres desarrollador, sabes que lo más pesado de integrar una IA en una aplicación es decidir cómo mostrar sus respuestas.

Hasta ahora, tenías dos opciones: o dejabas que el agente escupiera texto plano o te arriesgabas a que generara código HTML que luego debías limpiar y meter en un iframe, con todos los problemas de seguridad y diseño que eso conlleva.

A2UI cambia las reglas del juego. No es código ejecutable; es un estándar abierto que permite a los agentes hablar en «lenguaje de interfaz». En lugar de enviarte un bloque de texto o un script peligroso, el agente te envía un JSON declarativo.

Imaginalo como una receta: el agente te dice «necesito una tarjeta con este título, un selector de fecha y un botón de confirmación». Tú, como dueño de la aplicación, recibes ese JSON y lo mapeas automáticamente con tus propios componentes nativos.

Si trabajas con Flutter, React, Angular o SwiftUI, el resultado es una interfaz que se siente parte de tu app, con tus colores y tu tipografía, pero orquestada totalmente por la IA.

El fin de la «charla infinita»: Por qué el texto ya no es suficiente

Piénsalo un segundo. Si quieres reservar una mesa en tu restaurante favorito, ¿qué prefieres? ¿Escribir tres mensajes confirmando la hora, el número de personas y la zona de la terraza, o simplemente ver un pequeño formulario, tocar dos botones y listo?

Aquí es donde reside el verdadero valor de A2UI. La «densidad conversacional» es un problema real: las interacciones basadas solo en texto son lentas y agotan al usuario. La propuesta de Google ataca este dolor directamente.

Al permitir que el agente «proyecte» componentes interactivos en lugar de narrar cada paso, la fricción desaparece.

Pasamos de una conversación pesada a una interacción agéntica fluida. Ya no estás chateando con una máquina; estás colaborando con una herramienta que entiende que, a veces, un botón vale más que mil palabras.

Seguridad y Diseño: Los tres pilares de A2UI

El diseño de A2UI no es accidental; responde a tres necesidades críticas del desarrollo de software moderno:

Seguridad Radical

Uno de los mayores peligros de la IA es la «inyección de UI» o la ejecución de scripts maliciosos. A2UI soluciona esto tratando a la interfaz como datos, no como código. El cliente mantiene un catálogo de componentes de confianza.

El agente solo puede solicitar elementos de ese catálogo. No hay ejecución de scripts arbitrarios, solo una descripción de datos que el cliente traduce a una interfaz segura.

Amigabilidad con los LLM

Los modelos de lenguaje funcionan mejor cuando pueden procesar información de forma incremental. A2UI utiliza una representación «plana» de componentes.

Esto permite que el modelo genere o actualice partes específicas de la interfaz en tiempo real (streaming) sin tener que reenviar todo el árbol de componentes, lo cual ahorra latencia y tokens.

Portabilidad Total

Un mismo agente puede servir la misma lógica de UI a una aplicación web en React, una app móvil en Flutter y una herramienta de escritorio.

Al ser agnóstico al framework, A2UI garantiza que la identidad visual y el rendimiento sean consistentes en cualquier plataforma.

La Arquitectura: De la intención a la acción

El flujo de A2UI es una tubería elegante. Cuando un usuario envía un mensaje, el agente (potenciado por modelos como Gemini) genera una respuesta A2UI.

Este JSON viaja a través de protocolos de transporte como el Agent-to-Agent (A2A). Al llegar al cliente, la librería de renderizado de A2UI interpreta el payload y mapea cada componente a un widget concreto del sistema.

Lo más interesante es la interactividad: cuando el usuario pulsa un botón en la interfaz generada, esa acción se envía de vuelta al agente como un evento.

El agente procesa el evento y puede decidir actualizar la interfaz existente, cerrarla o abrir una nueva, creando un ciclo de feedback fluido y dinámico.

El ecosistema multi-agente y el futuro del estándar

A2UI cobra especial importancia en el mundo de las mallas de agentes (Multi-agent meshes). El agente externo no puede (ni debe) tener acceso al DOM o al código interno de la aplicación principal por razones de seguridad.

Con A2UI, ese agente externo puede enviar su interfaz de forma segura a través de la «frontera de confianza», permitiendo que la aplicación anfitriona mantenga el control total sobre la estética y la accesibilidad.

Google ha lanzado este proyecto en una fase temprana (v0.8) bajo la licencia Apache 2.0, lo que subraya su compromiso con el código abierto.

Actualmente, ya existen integraciones en proyectos de alto nivel como Gemini Enterprise, Flutter GenUI y Opal, demostrando que es una tecnología lista para ser explorada por ingenieros que construyen la próxima generación de aplicaciones.

A2UI y la evolución de la IA generativa

A2UI representa la madurez de la IA generativa. Ya no se trata solo de que la IA «piense» o «escriba», sino de que pueda «actuar» y «presentar» de manera que sea útil para el ser humano.

Al estandarizar la forma en que los agentes se comunican visualmente, Google no solo está facilitando el trabajo de los desarrolladores, sino que está sentando las bases para un internet donde la IA y la interfaz de usuario son una sola entidad dinámica y segura.

El protocolo A2UI es, sin duda, la pieza del rompecabezas que faltaba para que los agentes de IA se conviertan en herramientas verdaderamente integradas en nuestra vida digital cotidiana.