Los modelos capaces de generar contenido visual a partir de texto o imágenes están ganando cada vez más relevancia. Uno de los más recientemente presentados es Wan 2.1, desarrollado por Alibaba, una de las empresas tecnológicas más grandes de China.

Lanzado en febrero de 2025, este modelo chino de IA ha captado la atención de desarrolladores, creativos y empresas por su capacidad para crear videos e imágenes realistas de manera accesible y gratuita.

Pero, ¿qué hace a Wan 2.1 tan especial? Exploremos en detalle sus características, aplicaciones, cómo probarlo y cómo se compara con otros modelos de IA.

¿Qué es Wan 2.1?

Wan 2.1 es un modelo de inteligencia artificial de código abierto diseñado para generar videos e imágenes a partir de texto e imágenes de entrada. Que sea de código abierto significa que cualquiera puede usarlo, modificarlo y adaptarlo a sus necesidades sin costo alguno.

Su lanzamiento ha sido un hito importante en la democratización de la IA, permitiendo que tanto grandes empresas como pequeños desarrolladores puedan acceder a herramientas avanzadas de generación de contenido visual.

Alibaba ha puesto a disposición este modelo en plataformas como Alibaba Cloud’s ModelScope y en Hugging Face, facilitando su uso a nivel global. Además, su naturaleza de código abierto lo convierte en una opción atractiva para aquellos que buscan personalizar y mejorar el modelo según sus requerimientos específicos.

Aplicaciones de Wan 2.1

Las aplicaciones de Wan 2.1 son amplias y pueden impactar en múltiples industrias. A continuación, se presentan algunas de las más destacadas:

- Marketing: Las empresas pueden utilizar Wan 2.1 para crear anuncios personalizados y videos promocionales sin necesidad de equipos de producción costosos. Por ejemplo, es posible generar un video de un producto en acción simplemente describiendo la escena con palabras, lo que permite campañas más dinámicas y atractivas.

- Entretenimiento: En la industria del cine y la televisión, Wan 2.1 puede revolucionar la producción al generar efectos especiales, escenas completas o incluso cortometrajes, reduciendo tanto los tiempos como los costos de producción.

- Educación: Este modelo es ideal para crear videos instructivos o simulaciones interactivas, como tutoriales de ciencia o recreaciones históricas, haciendo que el aprendizaje sea más visual y accesible.

- Realidad Virtual (RV): Wan 2.1 tiene un gran potencial en la creación de contenido para entornos de RV, mejorando las experiencias inmersivas con videos e imágenes generados por IA que pueden rivalizar con producciones profesionales.

Un aspecto inesperado es su posible uso en la creación de mundos virtuales generativos, una tendencia emergente en 2025 que incluye juegos y simulaciones inmersivas. Esto abre nuevas posibilidades para desarrolladores de videojuegos y plataformas de metaverso.

Características Técnicas de Wan 2.1

Wan 2.1 está construido sobre una tecnología avanzada conocida como transformadores de difusión, que permite procesar grandes volúmenes de datos para generar resultados visuales realistas.

Una de sus innovaciones clave es el uso de un autoencoder variacional espaciotemporal (VAE), que mejora la capacidad del modelo para manejar movimientos complejos y transiciones fluidas en los videos generados.

Esto significa que Wan 2.1 no solo puede crear imágenes estáticas, sino también vídeos dinámicos con interacciones entre múltiples objetos. Por ejemplo, puede generar escenas como un perro montando una bicicleta o un gato boxeando, con un nivel de realismo que impresiona a los usuarios.

Variantes de Wan 2.1

El modelo Wan 2.1 está disponible en cuatro variantes diferentes, cada una diseñada para tareas específicas:

- T2V-1.3B: Genera videos a partir de texto con 1.3 mil millones de parámetros.

- T2V-14B: Una versión más potente para generar videos a partir de texto, con 14 mil millones de parámetros, ideal para tareas complejas.

- I2V-14B-720P: Genera videos a partir de imágenes con resolución de 720P.

- I2V-14B-480P: Similar a la anterior, pero con resolución de 480P, ofreciendo un equilibrio entre calidad y eficiencia.

Las variantes T2V se centran en la generación de videos a partir de descripciones textuales, mientras que las I2V permiten crear videos a partir de imágenes estáticas.

¿Cómo Probar Wan 2.1?

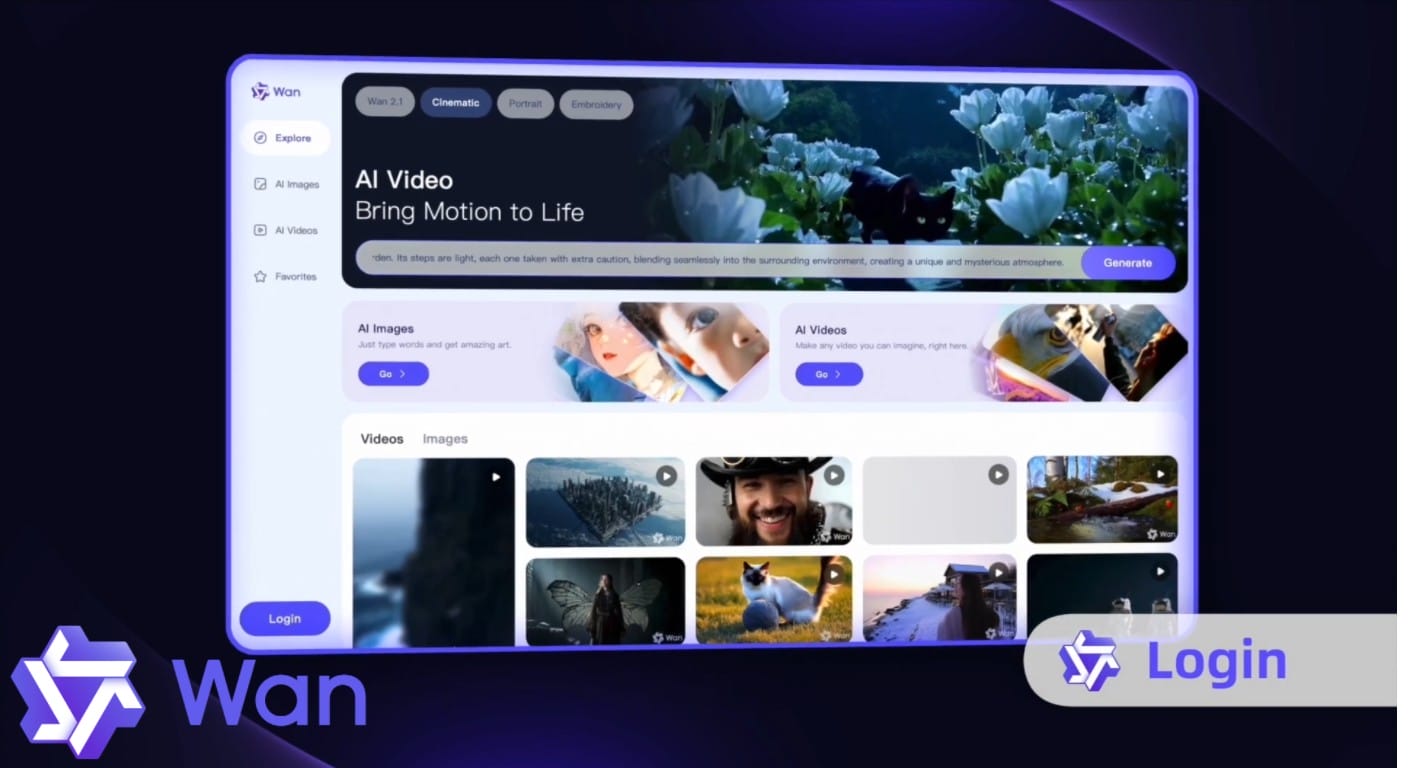

La manera más fácil y directa de probar Wan 2.1 es visitando su plataforma oficial: wan.video.

Este sitio te permite experimentar con el modelo de IA de Alibaba para crear videos e imágenes a partir de texto o imágenes de entrada, y está diseñado para ser accesible sin importar tu nivel de experiencia técnica. Para empezar, sigue estos pasos:

- Ingresa a wan.video.

- Regístrate o inicia sesión si la plataforma lo requiere.

- Sigue las instrucciones que aparecen en el sitio para generar contenido visual con Wan 2.1.

Es una opción intuitiva, gratuita y de código abierto, ideal tanto para principiantes como para usuarios avanzados que quieran explorar sus posibilidades sin costo alguno.

De forma secundaria, también puedes probar Wan 2.1 en plataformas como Alibaba Cloud’s ModelScope y Hugging Face, donde el modelo está disponible para uso o personalización.

¿Cómo se compara con otros modelos de IA?

Es común comparar Wan 2.1 con otros modelos de IA populares, como ChatGPT o Gemini. Sin embargo, es importante señalar que estos son modelos de lenguaje, enfocados en la generación y comprensión de texto, no en la creación de contenido visual. Por lo tanto, Wan 2.1 no compite directamente con ellos, sino que ofrece una funcionalidad complementaria.

Un modelo más comparable es Sora de OpenAI, que también genera videos a partir de texto. Según benchmarks como VBench, Wan 2.1 obtiene una puntuación general de aproximadamente 84.7%, superando a Sora en métricas clave como la calidad de generación de escena y la precisión en objetos individuales.

Además, mientras que Sora es un modelo propietario con acceso restringido, Wan 2.1 es de código abierto, lo que lo hace más accesible y personalizable para una amplia gama de usuarios.

Otros productos de Alibaba: Qwen y EMO

Alibaba no se ha limitado a desarrollar Wan 2.1; también ha creado otros modelos de IA que complementan su ecosistema tecnológico:

Qwen

Es una familia de modelos de lenguaje grande (LLMs) que incluye variantes como Qwen 2.5, lanzada en enero de 2025. Este modelo ha superado a competidores en tareas de razonamiento, comprensión de lenguaje y generación de código, consolidándose como una herramienta poderosa para desarrolladores y empresas.

EMO

Lanzado en febrero de 2024, EMO es un marco para generar videos de «talking head» a partir de una sola imagen y un archivo de audio. Esto permite crear avatares digitales realistas que pueden hablar o cantar, con aplicaciones en entretenimiento, redes sociales y creación de contenido personalizado.

Sin duda, este es solo el comienzo de lo que Alibaba y otros gigantes tecnológicos tienen preparado para el futuro de la IA.

Ya sea que estés buscando crear anuncios dinámicos, producir contenido educativo o explorar nuevas formas de entretenimiento, Wan 2.1 ofrece una oportunidad única para innovar sin las barreras tradicionales de costo y complejidad.