Si alguna vez te has preguntado cómo tu pulsera de actividad detecta una caída sin estar conectada al móvil, o cómo una cámara doméstica distingue a una persona de un gato sin mandar el vídeo a la nube, estás tocando el núcleo del Edge AI.

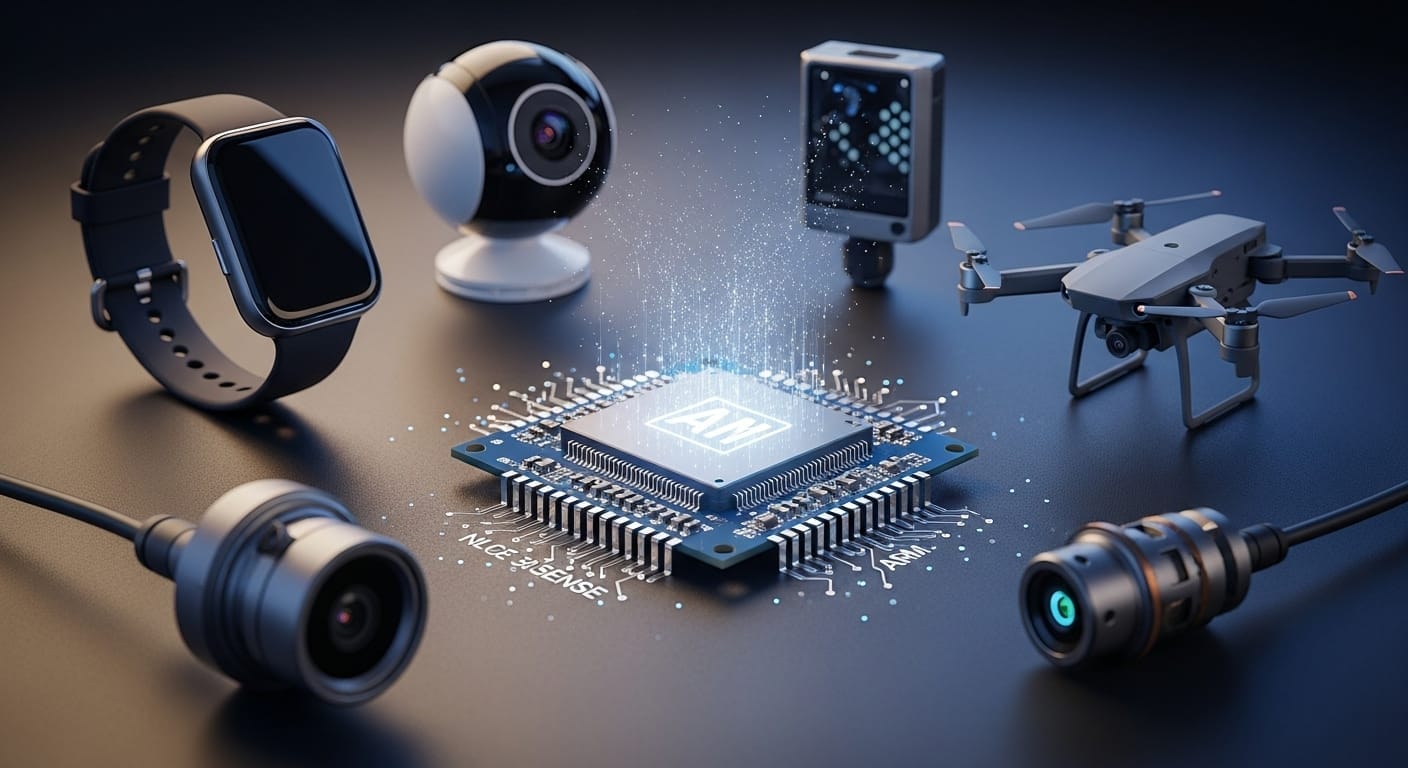

Llevar la inteligencia a dispositivos locales y sistemas de IoT es la nueva frontera tecnológica. Optimizar Algoritmos e Inteligencia Artificial para que funcionen fuera de la nube es esencial para el futuro de la computación distribuida.

Este artículo te lleva a lo esencial: qué es, por qué importa y cómo empezar a programar soluciones de IA que se ejecutan “en el borde” de la red.

Qué es el Edge Computing con IA

En el modelo tradicional, los dispositivos recogen datos y los envían a grandes servidores remotos para su procesamiento. El Edge Computing cambia esa regla: procesa los datos cerca de donde se generan (sensores, wearables, cámaras o microcontroladores) en lugar de depender siempre de la nube.

Cuando añadimos inteligencia artificial a ese procesamiento local hablamos de Edge AI o, en dispositivos muy limitados, TinyML.

Esto significa ejecutar modelos de machine learning directamente en hardware con recursos restringidos para habilitar respuestas en tiempo real (p. ej. detección de anomalías en una máquina, reconocimiento de voz en un wearable, o clasificación de imágenes en una cámara).

Algunas estimaciones proyectan que hacia comienzos de 2026 gran parte del procesamiento de datos empresariales se realizará en el edge. No es una moda: es una tendencia que empuja la computación hacia dónde realmente se necesita.

Ventajas clave de llevar la IA al Edge

¿Por qué no seguir procesando todo en la nube? Estas son las razones que marcan la diferencia:

- Latencia ultra-baja: para drones, robots o sistemas de seguridad, cada milisegundo cuenta. La inferencia local evita rondas de ida y vuelta a servidores remotos.

- Privacidad y seguridad: al procesar datos sensibles (imágenes, salud) localmente, reduces la exposición y el volumen de datos que viajan fuera del dispositivo.

- Eficiencia energética: modelos optimizados y específicos para edge consumen muy poco, permitiendo dispositivos a batería con larga autonomía.

- Independencia operativa: los dispositivos pueden seguir funcionando sin conexión estable a Internet, esencial para zonas remotas o entornos críticos.

El reto técnico: recursos muy limitados

Aquí está el truco para los programadores: muchos dispositivos edge tienen memoria y CPU muy ajustadas (desde decenas de kilobytes hasta unos pocos megabytes de RAM, según la plataforma).

Programar IA en el edge no es solo escribir código: es diseñar y adaptar modelos y sistemas para que entrenen en máquinas potentes, pero que se ejecuten eficientemente en chips modestos.

Modelos grandes tipo LLaMA o ResNet en su forma original no son prácticos para microcontroladores; la solución pasa por reducir, adaptar o rediseñar el modelo.

Herramientas y frameworks recomendados

No necesitas inventar la rueda. Estas herramientas te acompañarán desde la recopilación de datos hasta el despliegue:

- TensorFlow Lite / TFLite Micro: estándar muy usado para convertir modelos a formatos ligeros y ejecutarlos en microcontroladores.

- Edge Impulse: plataforma end-to-end ideal para principiantes: captura, entrenamiento, optimización y despliegue con herramientas visuales y un compilador pensado para edge.

- PyTorch Mobile: excelente para prototipado rápido en dispositivos móviles.

- ONNX Runtime: facilita interoperabilidad entre frameworks, útil si quieres evitar vendor lock-in.

Técnicas de optimización: cómo “hacer que quepa”

Para que un modelo funcione en un chip pequeño se aplican varias técnicas, a menudo combinadas:

- Cuantización (quantization): reduce la precisión de los pesos (por ejemplo, de 32-bit float a 8-bit entero). Esto disminuye el tamaño del modelo y acelera la inferencia con una pérdida mínima de precisión en muchos casos.

- Poda (pruning): elimina conexiones o neuronas que aportan poco, reduciendo parámetros y operaciones necesarias.

- Arquitecturas compactas: usar modelos diseñados para eficiencia —por ejemplo MobileNet, EfficientNet-Lite o variantes específicas para TinyML— en lugar de versiones pesadas.

- Destilación de conocimiento (knowledge distillation): entrenar un modelo pequeño (student) para imitar a uno grande (teacher), obteniendo buena precisión con menos recursos.

Herramientas como el TensorFlow Model Optimization Toolkit o los convertidores de TFLite facilitan aplicar estas optimizaciones.

Flujo de trabajo típico: de datos a dispositivo

Un ciclo de desarrollo habitual podría ser:

- Recolección de datos: captura con sensores reales (audio, acelerómetros, cámaras) cuidando la calidad y la diversidad.

- Entrenamiento: en tu PC o en la nube usando TensorFlow o PyTorch.

- Optimización: cuantización, poda y conversión a formatos ligeros (.tflite, ONNX optimizado).

- Integración y despliegue: compilar e incluir el modelo en firmware (C/C++), y probar en el hardware real.

Un proyecto clásico para comenzar es el Keyword Spotting: entrenar un modelo para reconocer una palabra como “sí” o “no”, optimizarlo para que ocupe menos de 100 KB y ejecutarlo en un Arduino o ESP32 con consumo muy bajo.

Hardware para prototipar según objetivos

No necesitas grandes inversiones para empezar:

- Nivel básico (TinyML): Arduino Nano 33 BLE Sense, ESP32 (económicos y perfectos para sensores)

- Visión y multimedia: Raspberry Pi 5 (buena opción si trabajas con cámara y necesitas algo flexible.)

- Alto rendimiento: NVIDIA Jetson Orin Nano (para robótica y visión avanzada).

Consejos finales

Programar IA en el edge es ingeniería creativa: equilibrar precisión, latencia y consumo. Empieza pequeño, prueba en hardware real y itera. Nuestra recomendación práctica: compra un kit económico, explora Edge Impulse o TensorFlow Lite y construye un proyecto sencillo en unas horas. Es la mejor manera de aprender y ver resultados reales.

El futuro está en el borde, pon manos a la obra y construye la próxima generación de dispositivos inteligentes.